김민수 DGIST 교수 연구팀, 'TrillionG 기술' 개발

그래프 빅데이터 분석·처리 기술의 표준 벤치마크로 활용 기대

DGIST(총장 손상혁)는 김민수 정보통신융합공학전공 교수 연구팀이 1조 간선으로 구성된 초대규모의 그래프 데이터를 일반 가정에서 사용하는 컴퓨터 일반 가정에서 사용하는 컴퓨터 10대를 사용해 2시간 만에 합성할 수 있는 트릴리온지(TrillionG) 기술을 개발했다고 31일 밝혔다.

현재 무척도(scale-free) 특성을 갖는 그래프를 정확하게 합성하기 위한 기술들은 메모리 기반 합성법이다. 이 방법은 많은 양의 네트워크 통신을 사용하기 때문에 합성 데이터 규모가 제한적이고 합성 속도가 느리다는 문제점이 존재했다.

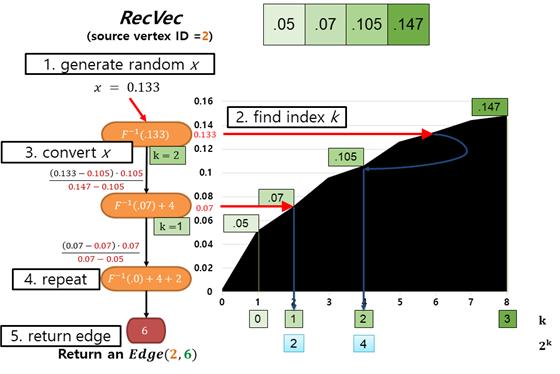

김민수 교수 연구팀이 개발한 트릴리온지 기술은 훨씬 더 큰 큐모의 그래프 데이터를 네트워크 통신 없이도 훨씬 더 빠른 속도로 합성할 수 있는 디스크 기반 기술이다. 김 교수팀은 재귀 벡터 모델이라는 독창적인 이론을 정립해 실제 시스템으로 구현함으로써 기존 기술의 문제점들을 해결했다.

연구팀이 개발한 트릴리온지 기술은 10대의 컴퓨터를 활용해 80억개의 간선으로 구성된 그래프 데이터를 72초 만에 합성했으며, 최대 4조 개의 간선들로 구성된 그래프 데이터를 합성할 수 있다. 기존 최고 기술로 알려진 Graph500 기술보다 합성 속도 면에서는 140배, 합성 규모 측면에서 500배 향상된 세계 최고 속도와 최대 규모의 성능을 나타냈다.

지금까지 합성된 세계 최대 규모의 그래프 데이터는 미국 IBM 슈퍼컴퓨터 세콰이어를 활용해 Grapg500 기술로 합성한 32조 간선 규모의 그래프 데이터다.

그런 가운데 연구팀이 개발한 기술을 활용하면 80대의 컴퓨터로 동일한 규모의 데이터를 합성할 수 있다. 연구팀은 이 기술의 강확장성 특성으로 인해 100조 간선 규모로 알려진 인간 뇌 신경망 데이터도 약 240대의 컴퓨터만으로 합성할 수 있을 것으로 예상하고 있다.

김민수 교수는 "AI와 뇌과학 분야에서 점점 중요해지고 있는 그래프 데이터를 초대규모, 초고속으로 합성할 수 있는 원천 기술을 확보했다"며 "산업적인 측면에서 그래프 빅데이터를 분석·처리하는 기술들에서 표준 벤치마크로 활용될 수 있을 것"이라고 말했다.

이번 연구는 삼성미래기술육성사업 과제의 지원으로 수행됐으며, 연구결과는 지난 17일 미국 시카고에서 열린 데이터베이스 학술대회인 '2017 ACM SIGMOD'에서 발표됐다.

댓글 정렬